Nel caso non fosse già chiaro, gli ultimi casi di cronaca lo hanno reso lampante: gli Stati Uniti hanno un serio problema sociale (e politico) con le armi da fuoco, e in particolare con regolamentazione del loro acquisto e possesso. Ma all’orizzonte si è affacciata una questione ancora più spinosa che sta già sollevando feroci polemiche e che, sì, riguarda le armi, ma non nel senso tradizionale del termine.

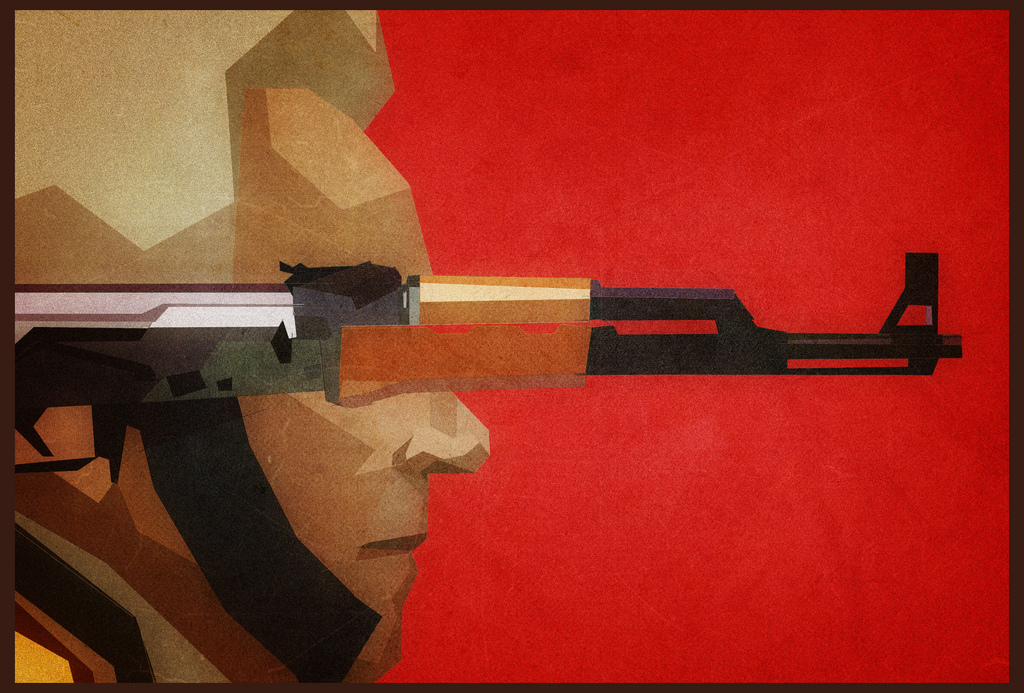

Immaginate di entrare in un negozio di una cittadina della provincia americana e di comprare l’ultimo modello di fucile. Il commesso vi chiede un documento di identità, controlla sul database se avete precedenti penali o problemi clinici, poi vi consegna una specie di kalashnikov dotato di intelligenza artificiale, un’arma micidiale che, anche se non avete mai sparato un colpo in vita vostra, vi permetterà di centrare i vostri bersagli senza nemmeno prendere la mira.

E va bene, forse ci sono andato giù un po’ pesante, ma lo scenario che ho descritto non è così lontano quanto vorremmo sperare.

Lo scorso aprile, durante un meeting delle Nazioni Unite a Ginevra, il governo britannico si è esplicitamente opposto alla possibilità di bandire le cosiddette LAWS (Lethal Autonomous Weapons Systems), ossia quel tipo di armi autonome che sono in grado di individuare e colpire bersagli di vario tipo senza bisogno dell’intervento dell’uomo; un tipo di armamento su cui la ricerca militare sta investendo molto e che è già diventato oggetto di critica da parte di svariate associazioni umanitarie.

In questi giorni, personalità del calibro di Stephen Hawking, Elon Musk, Noam Chomsky, Steve Wozniak e un migliaio tra ricercatori ed esperti in intelligenze artificiali, hanno sottoscritto una lettera aperta promossa dall’associazione Future Of Life, in cui si chiede che questo tipo di ricerca venga ostacolato a livello internazionale.

“L’intelligenza artificiale (IA) ha raggiunto un punto in cui lo sviluppo di armi autonome è un’eventualità che – praticamente anche se non legalmente – potrebbe concretizzarsi nel giro di anni: le armi autonome sono già state descritte come la terza rivoluzione in ambito bellico, dopo la polvere da sparo e le armi nuclari. […] Come la maggior parte dei chimici e dei biologi non ha interesse nella creazione di armi chimiche o biologiche, la maggior parte dei ricercatori IA non ha interesse nella creazione di armi intelligenti – e non vogliono che altri compromettano un intero campo perseguendo questo tipo di obiettivi.”

I firmatari temono che l’utilizzo di intelligenze artificiali vada a penalizzare, agli occhi dell’opinione pubblica, l’intero settore di ricerca delle intelligenze artificiali; nel contempo ci tengono a sottolineare quale sia il vero rischio connesso allo sviluppo di armi autonome: che diventino di uso comune.

“Se una qualsiasi delle più grandi potenze militari decide di sviluppare armi intelligenti, una corsa alle armi globale sarà virtualmente inevitabile, e il punto di arrivo di questa traiettoria tecnologica è ovvio: le armi automatiche saranno i kalashnikov del domani.”

Il riferimento ai kalashnikov non è casuale, l’AK-47 è noto per essere stato il fucile d’assalto più utilizzato nel mondo, per via del costo relativamente basso dei suoi materiali e della sua affidabilità. Il punto di arrivo di cui parla la lettera di Future Of Life è una situazione in cui le armi autonome saranno non solo disponibili, ma anche facilmente riproducibili in casa (attraverso, per dire, la stampa 3D), creando una situazione ancora meno controllabile di quella attuale.

Alla luce di queste considerazioni, l’esempio fatto a inizio pezzo appare d’un tratto molto meno gratuito.